摘要:爬虫软件工程师教你怎么做SEO,没有什么比我们更了解搜索引擎我们接触的都是数据聚合类的网站至少千万数据或搜索引擎。百度蜘蛛抓取策略我就是使用爬虫软件+技术处理打造了一个权6的网站

爬虫软件工程师教你如何做SEO,没有人比我们更了解搜索引擎,我们接触的数据聚合网站,至少几千万的数据还是搜索引擎的,URL是人类设定的供爬虫爬取的网址,可以理解为爬取的入口URL,然后通过其内部链接进行传播和爬取。

搜索引擎原则

在搜索引擎网站的后台,会有一个非常庞大的索引库,里面存储着大量的关键词,而每个关键词又对应着很多个URL。这些URL都是被称为“搜索引擎蜘蛛”或者“网络爬虫”的程序从浩瀚的互联网上一点一点收集起来的。随着各类网站的出现,这些辛勤工作的“蜘蛛”每天都在互联网上爬行,从一个链接到另一个链接,下载内容,进行分析提炼,找出关键词。如果“蜘蛛”认为这个关键词不在数据库中,而且对用户有用,就会存入后台数据库。相反,如果“蜘蛛”认为这是垃圾信息或者重复信息,就会将其丢弃,继续爬行,寻找最新的、有用的信息保存下来,提供给用户搜索。当用户搜索时,就可以从索引库中检索出与关键词相关的URL,展示给访问者。一个关键词对应多个URL,这样就存在排序的问题,与关键词最匹配的对应网站的URL就会排在前面。 在“蜘蛛”抓取网页内容、提炼关键词的过程中,有一个问题:“蜘蛛”能否看懂。如果网站内容都是Flash、JS,那么就算关键词相关,也是看不懂的。相应的,如果网站内容能被搜索引擎识别,那么搜索引擎就会增加网站的权重,增加网站的友好度,从而提高网站的排名。

百度收录为何难?大批网站遭封禁原因明日再发

百度蜘蛛下载的网页放在补充数据区,经过各种程序计算后形成稳定的排名百度蜘蛛抓取但是不收录一个月了,再放在搜索区,所以只要下载的数据有,都可以通过指令找到。补充数据不稳定,在各种计算过程中可能会被淘汰。搜索区的数据排名比较稳定。百度目前将缓存机制与补充数据结合起来,正在向补充数据转型。

百度蜘蛛爬行策略

深度优先与权重优先。百度蜘蛛在爬取网页时,都是从起始站(也就是种子站,指一些门户网站)开始爬取的,百度为了爬取更多的网址,会进行优先爬取。深度优先爬取的目的是为了爬取优质网页,这个策略是通过调度计算和分配的,百度蜘蛛只负责爬取。权重优先是指优先爬取反向链接较多的网页,这也是一种调度策略。一般情况下,爬取40%的网页属于正常范围,60%就很不错了,100%是不可能的,当然爬取的越多越好。

不要触犯搜索引擎最大的禁忌

百度蜘蛛好像更注重网站页面的层次结构,和Google相比,百度蜘蛛更注重网站内部页面结构的层次,有点像爬虫,越黑越深,越喜欢往里钻,它就不信百度蜘蛛抓取但是不收录一个月了,就算你做了100个页面,再漂亮,只要链接不分层,最多也就孤独地在索引里混个可怜兮兮的小东西。

搜索引擎告诉你如何做SEO?

无论站长制作什么类型的网站,网站内部结构一定要简洁明了,这是站长需要知道的一点。一般网站设计时,页面层级不要超过三级,现在很多仓库货架的网站层级都超过三级。页面文件名可以用字母或者数字,但千万不要用很长的中英文转换插件,那样对收录没有任何好处。而且在网站建设过程中添加内容时,建议大家使用静态或者伪静态技术生成处理,这样有利于网站在搜索引擎的友好度。

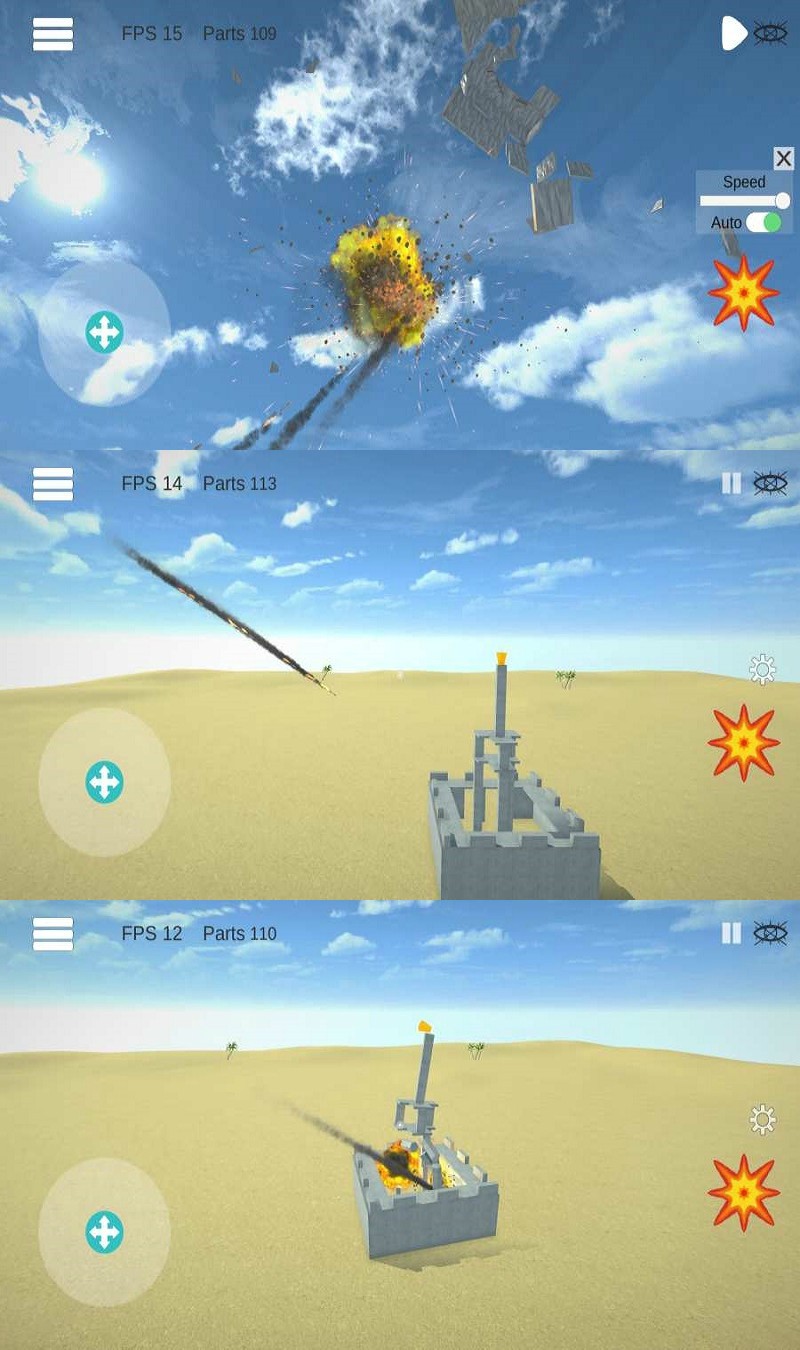

我使用爬虫软件+技术处理创建了一个权限为6的网站

采集伪原创内容:TensorFlow人工智能引擎/分词算法/DNN算法采用多线程分段精度处理,结合机器学习、人工智能、百度大脑的自然语言分词、词性分析、词汇依存等相关技术,让所有搜索引擎都认为这是一篇原创文章

图像伪原创:背景融合算法可以将一幅图像伪原创为N幅原始图像

模板伪原创:更改图片名称、js名称、css名称、更改图片MD5、更改class样式名称

网站发布商:帝国、EasyYou、ZBLOG、Dreamweaver、WP、小龙卷风、站群、PB、苹果、搜外等。

看完本文,如果你觉得有用,不妨保存或者发送给你可能需要的朋友、同事!